Künstliche Intelligenz (KI) unterstützt Entscheidungen von Personalverantwortlichen und Führungskräften z.B. im Recruiting und der Personalauswahl, im Talent- und Karrieremanagement sowie im Skillmatching. Sind diese Systeme tatsächlich objektiver?

Autorin: Steffi Bärmann

Ergebnisse KI-unterstützter Systeme als Entscheidungsgrundlage

Dabei werden sowohl Daten von Bewerbenden und Mitarbeitenden als auch relevante Daten aus dem Internet KI-gestützt gesammelt, bewertet und zugeordnet. Hierarchisch übergeordnete Führungskräfte und Personalverantwortliche greifen auf die Ergebnisse zu und verwenden Sie u.a. als Entscheidungsgrundlage u.a. für die Besetzung neuer Positionen, Beförderungen oder in Gehaltsfragen.

Ziel des Einsatzes sind neben Effizienz und Kostensenkungen auch eine Qualitäts- und Leistungsverbesserung u.a. von Entscheidungen. Diese könnten objektiver sein und menschlichen Bias vermeiden. Methoden der KI beziehen ihre Daten in der Regel aus der Vergangenheit; ist in diesen Daten ein Bias vorhanden, wird der automatisch, sozusagen unterbewusst übernommen und weitergetragen. Berichte von Diskriminierung werden daher regelmäßig bekannt.

Daher ist es relevant zu klären, wie Fairness bei der Anwendung von KI-unterstützten Entscheidungssystemen im Personalmanagement gefördert werden kann.

Der Begriff der Fairness wird in der Literatur unterschiedlich nuanciert, und ist mit dem Begriff der Gerechtigkeit verbunden. Eine gerechte Entscheidung wird als fair wahrgenommen. Fühlen sich Mitarbeitende/ Bewerbende unfair behandelt, führt das zu einem Vertrauensverlust und die Kooperationsbereitschaft sinkt.

KI-System versus Führungskraft

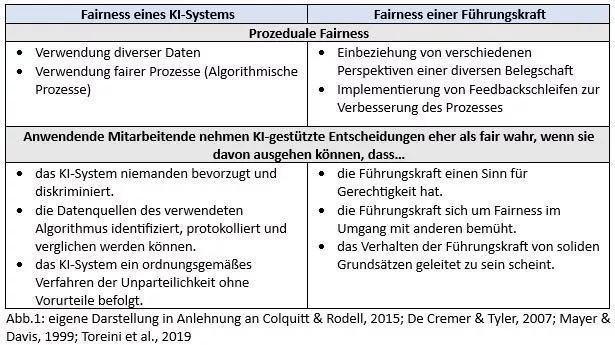

Die oben beschriebene Hoffnung, ein KI-unterstütztes Entscheidungssystem könnte „besser“ nämlich fairer sein als eine menschliche Entscheidung hat sich zumindest derzeit noch als unerfüllbar erwiesen. Kate Crawford (2017) argumentiert: KI-Systeme bildet menschliche Systeme ab, daher kann das nicht nur aus einer technologischen oder nur aus einer soziologischen Perspektive betrachtet werden, sondern bedarf beides. Abbildung 1 zeigt Aspekte beider Perspektiven auf prozeduraler Ebene und aus der Wahrnehmung der anwendenden Mitarbeitenden auf.

Die Fairness in der Anwendung von KI-unterstützten Systemen fördern

In einem nächsten Schritt wird nun versucht aus diesen Aspekten heraus, Möglichkeiten abzuleiten, die Fairness in der Anwendung von KI-unterstützten Entscheidungssystemen im Personalmanagement zu fördern.

- Aus technologischer Sicht kann sich Fairness eines Systems erst in den wahrgenommenen Ergebnissen zeigen. Um diese zu erreichen, ist es wichtig, dass es einen Prozess der Datensammlung und Datenbereinigung gibt, der Fairness fördert.

- In diesen Prozess sind Menschen eingebunden, d.h. in erster Linie Data Scientists und Fachkräfte (hier aus dem Personalmanagement) und auch Führungskräfte. Prozedurale Fairness wird durch die Einbindung von Mitarbeitenden gefördert. Es wird daher empfohlen, Anwendende, bei der Implementierung von KI-Systemen mit einzubeziehen und Feedbackmöglichkeiten zu geben.

- Auch in weiterer Folge der Anwendung wird menschliches Feedback, kontinuierliche Kontrolle und Evaluation der Ergebnisse als notwendig erachtet, um Unfairness und Bias zu erkennen und entgegenzuwirken.

- Vielfältige Perspektiven unterstützen Fairness in Entscheidungsprozessen. Daher wirken sowohl eine Diversität der verwendeten Daten als auch eine diverse Belegschaft als förderlich.

- Fairness wird durch Transparenz und Nachvollziehbarkeit von Entscheidungsprozessen gefördert. KI-Systeme sollten daher ihre Aufgaben in einer Form erfüllen, dass die Mitarbeitenden verstehen können, wie Entscheidungen getroffen werden.

- Das Thema Fairness im Kontext Technologieanwendung ist erst seit 2017 in Wissenschaft & Praxis angekommen. Eine Sensibilisierung der anwendenden Stakeholder aller Hierarchiestufen z.B. durch Forschung und entsprechende Weiterbildungen sowohl in technologischer Hinsicht als auch in Bezug auf die möglichen Auswirkungen auf die Nutzenden kann hier unterstützend sein.

- Die Anwendung KI-gestützter Systeme setzt die Einhaltung rechtlicher Rahmenbedingungen voraus. Dazu gehören neben der DSGVO auch das Antidiskriminierungsgesetz und (zukünftig) der EU AI Act.

Fazit

Insgesamt zeigt sich, dass die Förderung von Fairness bei der Anwendung von KI-unterstützten Entscheidungssystemen im Personalmanagement eine integrative Anstrengung erfordert, die technologische, soziale und rechtliche Aspekte gleichermaßen berücksichtigt. Nur durch eine ausgewogene Herangehensweise können die Potenziale der KI genutzt werden, ohne unerwünschte Auswirkungen auf Fairness und Vertrauen zu generieren.

Quellen & empfohlene Literatur

- Colquitt, J. A., & Rodell, J. B. (2015). Measuring Justice and Fairness. In R. S. Cropanzano & M. L. Ambrose (Hrsg.), The Oxford Handbook of Justice in the Workplace. Oxford University Press. https://doi.org/10.1093/oxfordhb/9780199981410.013.8

- De Cremer, D., & Tyler, T. R. (2007). The effects of trust in authority and procedural fairness on cooperation. Journal of Applied Psychology, 92(3), 639–649. https://doi.org/10.1037/0021-9010.92.3.639

- Crawford, Kate (2017). The Trouble with Bias – NIPS 2017 Keynote – Kate Crawford #NIPS2017. abgerufen am 22.11.2023: https://youtu.be/fMym_BKWQzk?si=eXv47GbtbVSU65vI

- Mayer, R. C., & Davis, J. H. (1999). The Effect of the Performance Appraisal System on Trust for Management: A Field Quasi-Experiment. Journal of Applied Psychology, 84(No. 1), 123–136.

- Schoeffer, J., Machowski, Y., & Kuehl, N. (2021). A Study on Fairness and Trust Perceptions in Automated Decision Making (arXiv:2103.04757). arXiv. http://arxiv.org/abs/2103.04757

- Toreini, E., Aitken, M., Coopamootoo, K., Elliott, K., Zelaya, C. G., & van Moorsel, A. (2020). The relationship between trust in AI and trustworthy machine learning technologies. Proceedings of the 2020 Conference on Fairness, Accountability, and Transparency, 272–283. https://doi.org/10.1145/3351095.3372834

- van den Bos, K., Wilke, H. A. M., & Lind, E. A. (1998). When do we need procedural fairness? The role of trust in authority. Journal of Personality and Social Psychology, 75(6), 1449–1458. https://doi.org/10.1037/0022-3514.75.6.1449

Was heißt hier fair? | KI-unterstützte Entscheidungssysteme im HR | HR-Entscheidungssysteme